¿Cómo se mide la calidad de los modelos de lenguaje?

Una exploración sobre las evaluaciones más comunes para medir las capacidades de los modelos de lenguaje y las limitaciones de estas.

Después de unas semanas de vacaciones, las Loras Mojadas vuelven con un artículo sobre las distintas formas en las que se mide y evalúa la calidad de los modelos de lenguaje. Sin embargo, antes de entrar en materia, quiero invitarlos a que me envíen un correo con cualquier tema que les interese o sobre el que tengan inquietudes. Me encantaría oírlos y pensar en los artículos que vienen con sus ideas y preguntas en mente.

Si están suscritos, pueden simplemente responder a este correo. Si no, pueden escribirme a: loras@yabra.co 🦜

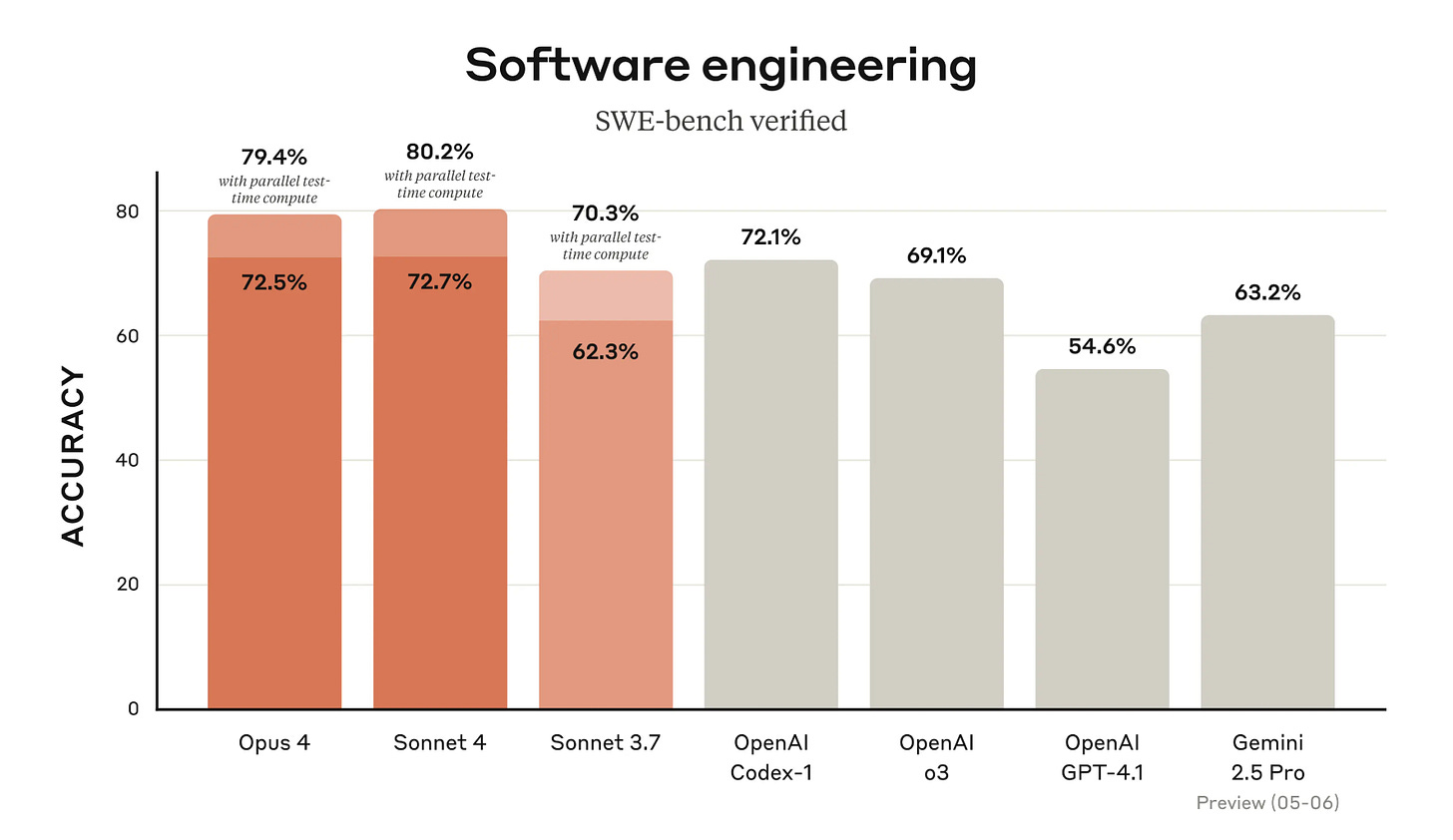

En la intensa competencia por captar la mayor cantidad de usuarios, cada vez que una empresa hace público un nuevo modelo de lenguaje, acompaña este lanzamiento con cifras que “demuestran” su superioridad. Solo hace unas semanas, por ejemplo, Anthropic lanzó Claude Opus 4 y Claude Sonnet 4 publicando gráficas como la siguiente:

¿Qué significan estos números? Y, de forma más general, ¿cómo se evalúa la calidad de los modelos de lenguaje? ¿qué tipo de capacidades estamos evaluando? En este artículo voy a abordar estas preguntas explicando las metodologías más comunes para evaluar modelos de lenguaje y resaltando algunos de los problemas y limitaciones de estas.

Creando pruebas estandarizadas para modelos de lenguaje

Evaluar un modelo de lenguaje es, en esencia, verificar sistemáticamente y con una gran cantidad de ejemplos la capacidad del modelo para resolver problemas en un área. Podríamos, por ejemplo, poner a una historiadora experta a hacerle preguntas a uno de estos modelos y pedirle que evalúe sus conocimientos en historia. Pero este proceso no sería ni sistemático ni viable de implementar a escala. Así que, imitando — e incluso muchas veces usando— las pruebas estandarizadas que se les aplican a estudiantes de escuelas y universidades, los investigadores en el campo han creado una serie de pruebas estandarizadas específicas para modelos de lenguaje.

Estas pruebas utilizan en muchas ocasiones recursos ya existentes y disponibles en línea para compilar una serie de preguntas y respuestas. Para darles una idea más concreta, a continuación describo dos de las pruebas más populares.

Comprensión Multitarea Masiva del Lenguaje (MMLU en inglés): Creada por Hendrycks y coautores en el 2021, esta prueba contienen más de 15 000 preguntas de opción múltiple que abarcan 57 áreas del conocimiento como matemáticas, historia de Estados Unidos, ciencias de la computación y derecho. Los datos de esta prueba se recopilaron manualmente de fuentes públicas (exámenes estandarizados de nivel universitario como el GRE, exámenes universitarios, libros de Oxford, etc.). El diagrama 2 muestra una pregunta de microeconomía y las cuatro opciones de respuesta (la correcta está resaltada en verde):

HellaSwag: Desarrollada por Zellers y coautores en el 2019, HellaSwag es una prueba de razonamiento de sentido común en la que los modelos deben elegir, entre varias opciones, la continuación más coherente para una situación dada. Los enunciados presentan interacciones físicas, relaciones de causa y efecto y conocimientos cotidianos, de modo que la tarea mide la comprensión más allá de patrones estadísticos. La prueba incluye 39 905 preguntas que provienen de dos fuentes principales: el conjunto ActivityNet Captions, que contiene descripciones textuales de actividades humanas, y los artículos de WikiHow, que ofrecen instrucciones paso a paso para diversas tareas. El diagrama 3 muestra un ejemplo:

Pruebas especializadas

Además de las pruebas estandarizadas que evalúan conocimientos generales en múltiples disciplinas, existen conjuntos de evaluaciones diseñadas para medir con mayor profundidad habilidades muy concretas. En particular, los modelos de lenguaje suelen ponerse a prueba en dominios como las matemáticas de nivel avanzado y la generación de código.

Matemáticas.

Pruebas como MATH evalúan la capacidad de resolución de problemas matemáticos de alta dificultada en modelos de lenguaje. Esta prueba contiene 12 500 problemas matemáticos utilizados en competencias con sus respectivas respuestas.

Desarrollo de código.

HumanEval: Desarrollada por OpenAI, esta prueba contiene 164 desafíos de programación en Python, cada uno con una descripción textual de la función a implementar y un conjunto de evaluaciones que validan su correcto funcionamiento. Por ejemplo, esta prueba puede incluir desafíos en los que se le pida al modelo de lenguaje que escriba una función de Python que calcule la raíz cuadrado de un número.

SWE-bench: Contiene 2 294 problemas tomados de proyectos reales en Python. Para cada caso, el modelo recibe un fragmento de código que no funciona y una explicación sencilla del error (“esta función no calcula bien el impuesto”, por ejemplo). El reto consiste en entregar el código corregido para que pase una serie de pruebas que verifican su funcionamiento. Esta es la misma prueba que se ve en el diagrama 1, donde Anthropic evalúa a sus nuevos modelos y muestra su superioridad.

Modelos compitiendo por el reconocimiento humano

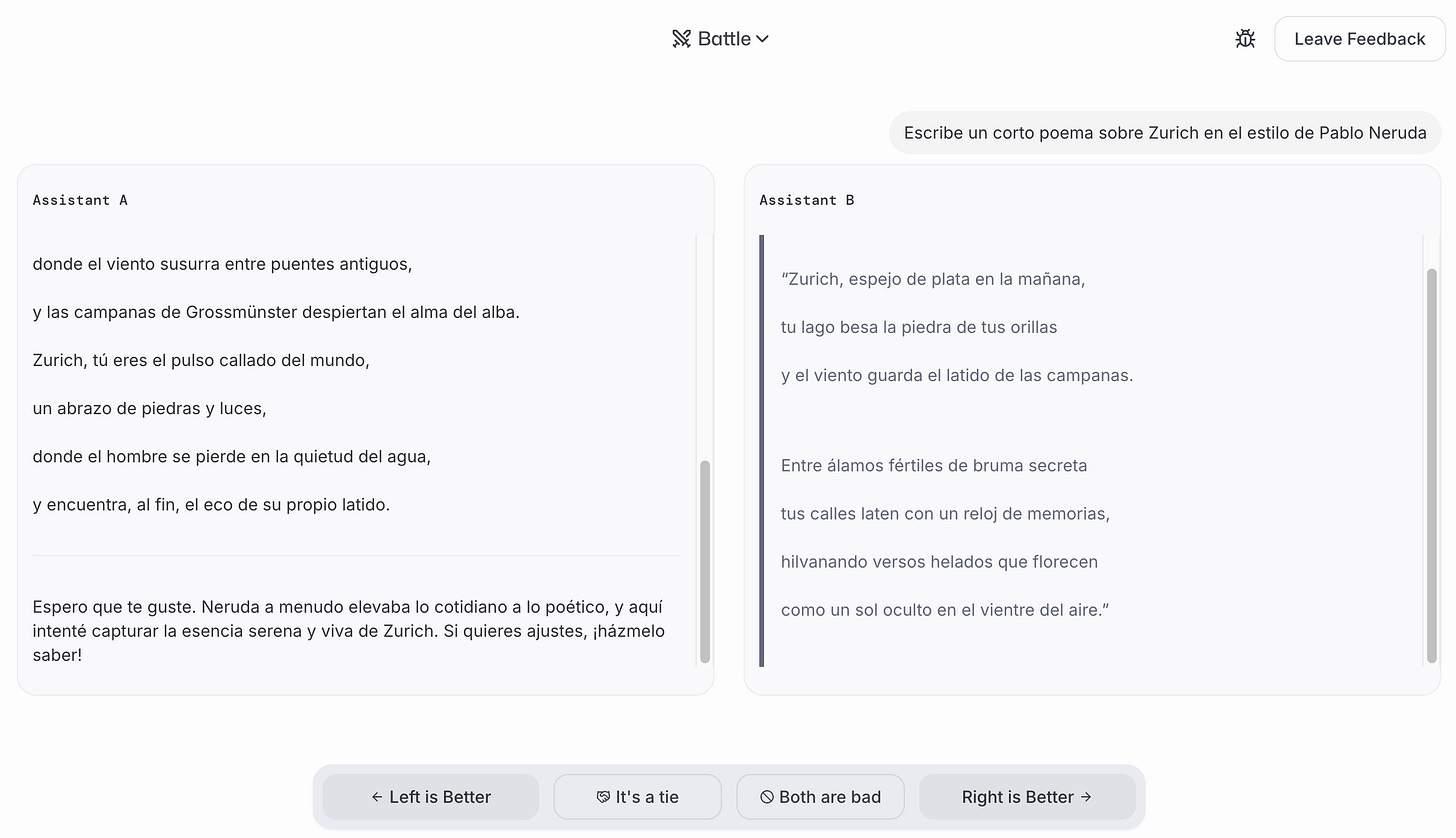

Las pruebas estandarizadas nos dan información sobre los conocimientos y capacidades de los modelos en areas donde existen respuestas claras sobre las que hay consenso (por ejemplo, la respuesta a una problema matemático). Sin embargo, hay muchas otras tareas que realizan los modelos de lenguaje que no pueden ser evaluadas de esta forma. ¿Cómo evaluar, por ejemplo, el resultado de pedirle a un modelo que escriba un poema en el estilo de Pablo Neruda? La respuesta del equipo de investigadores detrás de LM Arena es sencilla: poniendo a competir los modelos entre si y pidiendo a los humanos que escojan el ganador.

El diagrama 4 muestra un ejemplo de esta competencia. Las respuestas de los modelos son presentadas de forma anónima y los usuarios escogen la mejor respuesta. También existe la opción de empate o de clasificar ambas respuestas como malas. Con estas comparaciones de parejas en cualquier tipo de tarea que los usuarios quieran, LM Arena genera un ranking de los mejores modelos. A día de hoy, el mejor modelo es Gemini 2.5-pro-preview de Google.

Algunos problemas y limitaciones

A la hora de confiar en evaluaciones estandarizadas para comparar modelos de lenguaje, surgen tres limitaciones principales que quiero resaltar:

Filtración de datos

Uno de los problemas más recurrentes es la posible presencia de datos de las pruebas en el corpus de entrenamiento de los modelos. Cuando un modelo “ha visto” preguntas o fragmentos de una prueba durante su preentrenamiento, la puntuación que obtenga no reflejará su capacidad real, sino más bien el recuerdo de patrones aprendidos de forma directa. Este fenómeno es conocido como filtración de datos. Es como si un estudiante tiene acceso a las preguntas y respuestas de un examen antes de realizar el examen.

El impacto de esta filtración es doble: por un lado, dificulta la comparación justa entre distintos modelos (¿qué pasa si algunos modelos han “visto” en su entrenamiento las preguntas de la prueba y otros no?). Por otro, conduce a falsas expectativas de progreso en la investigación: pareciera que los modelos mejoran de forma exponencial, cuando parte de esa mejora es el resultado de haber “visto” antes los exámenes que se les aplica.

Representatividad de las tareas e idiomas

Otro reto clave es que muchas pruebas estandarizadas se concentran en dominios muy concretos o en idiomas pocos idiomas (sobre todo el inglés). Esto genera dos sesgos principales:

Sesgo de dominio. Pruebas como MMLU o HumanEval evalúan áreas del conocimiento (matemáticas, programación en Python, historia universitaria) que no necesariamente reflejan los usos reales que las personas le dan a un modelo de lenguaje. Si un modelo obtiene un 90 % en MMLU, podríamos pensar que “entiende” de historia o de leyes, pero esto no garantiza que sea capaz de redactar un contrato legal o de resumir textos médicos complejos. En la práctica, muchas aplicaciones cotidianas quedan fuera de estas evaluaciones tradicionales.

Sesgo de idioma. Como vimos en artículos anteriores, el inglés domina los conjuntos de entrenamiento y, por tanto, la mayoría de las pruebas. Esto implica que los modelos suelen rendir mejor en tareas en inglés que en otras lenguas. Por ejemplo, un modelo de lenguaje puede resolver con fluidez ejercicios de programación expresados en inglés, pero fallar al interpretar un enunciado idéntico en español, italiano o swahili. El riesgo es subestimar las necesidades de quienes trabajan o consultan en otros idiomas: si no existen evaluaciones en lenguas distintas al inglés, no sabremos si el modelo realmente funciona bien para esas comunidades.

Ley de Goodhart e incentivos perversos.

Quizá el problema más profundo de todos es que, al centrar la atención en ciertas evaluaciones, corremos el riesgo de sobreajustar los modelos a las pruebas mismas y no al objetivo último que persiguen: servir al usuario en escenarios reales. Este fenómeno se puede entender a través de la famosa Ley de Goodhart, que por lo general se resume como: “Cuando una métrica se convierte en objetivo, deja de ser una buena métrica”. Aplicado a los modelos de lenguaje, significa que, si las empresas y laboratorios ponen demasiado énfasis en mejorar puntuaciones de evaluaciones particulares, los modelos terminarán encontrando atajos para maximizar esa métrica, muchas veces sin que las mejoras se traduzcan en un mejor modelo.

Conclusión

En resumen, si bien las pruebas estandarizadas han sido fundamentales para medir el progreso de los LLMs, no son infalibles. La filtración de datos, la falta de representatividad de las tareas e idiomas, y los incentivos que pueden desviar a los modelos de servir realmente a los usuarios son desafíos que no podemos ignorar. Avanzar hacia evaluaciones más robustas, transparentes y orientadas a casos de uso reales será clave para construir modelos que, además de “lucir bien” en las gráficas, ofrezcan un valor auténtico y sostenible en la práctica.

Tres cosas que descubrí esta semana

Una aplicación para hacer presentaciones. Gamma.app es una aplicación que incorpora modelos de lenguaje para facilitar la creación de presentaciones. Yo no la he usado pero la conocí por un tutorial que hizo el equipo de la CafeterIA (un espacio donde hablan de IA cada semana). Acá les dejo el enlace del tutorial.

Visiones críticas sobre IA. El viernes pasado, el instituto de investigación Data & Society hizo un evento en línea sobre dos nuevos libros (The AI Con y Empire of AI) que problematizan el panorama actual en el campo de la inteligencia artificial. Acá la página del evento donde seguramente pronto encontrarán la grabación del evento.

Modelos que generan videos. Google lanzó un nuevo modelo (Veo 3) capaz de crear videos con sonido. El video promocional del modelo incluye lo que yo creo es un pequeño guiño a Loras Mojadas 😅 (vayan al minuto 0:37).